Reinforcement learning är ett område inom maskininlärning. Det handlar om att vidta lämpliga åtgärder för att maximera belöningen i en viss situation. Det används av olika programvaror och maskiner för att hitta det bästa möjliga beteendet eller den väg den bör ta i en viss situation. Förstärkningsinlärning skiljer sig från övervakad inlärning på så sätt att i övervakad inlärning har träningsdata svarsnyckeln med sig så att modellen tränas med det korrekta svaret själv, medan det i förstärkningsinlärning inte finns något svar utan förstärkningsagenten bestämmer vad som ska göras för att utföra den givna uppgiften. I avsaknad av en träningsdatamängd måste den lära sig av sin erfarenhet.

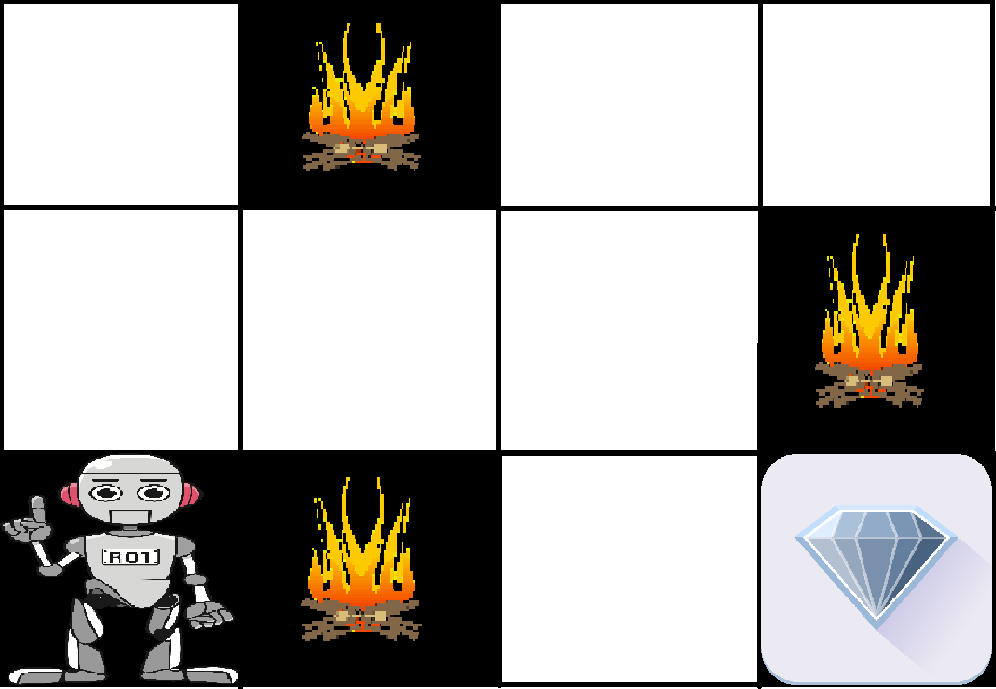

Exempel: Problemet är följande: Vi har en agent och en belöning, med många hinder däremellan. Agenten ska hitta den bästa möjliga vägen för att nå belöningen. Följande problem förklarar problemet lättare.

Ovanstående bild visar roboten, diamanten och elden. Robotens mål är att hämta belöningen som är diamanten och undvika hindren som är eld. Roboten lär sig genom att prova alla möjliga vägar och sedan välja den väg som ger honom belöningen med minst antal hinder. Varje rätt steg ger roboten en belöning och varje fel steg drar bort robotens belöning. Den totala belöningen beräknas när den når den slutliga belöningen som är diamanten.

Huvudpunkterna i Reinforcement learning –

- Input: Ingången ska vara ett initialtillstånd från vilket modellen startar

- Output: Det finns många möjliga utdata eftersom det finns många olika lösningar på ett visst problem

- Träning: Modellen returnerar ett tillstånd och användaren bestämmer sig för att belöna eller straffa modellen baserat på dess resultat.

- Modellen fortsätter att lära sig.

- Den bästa lösningen bestäms baserat på maximal belöning.

Skillnaden mellan förstärkningsinlärning och övervakad inlärning: Den bästa lösningen bestäms baserat på maximal belöning:

| Reinforcement learning | Supervised learning | ||

|---|---|---|---|

| Reinforcement learning handlar om att fatta beslut i sekvens. Med enkla ord kan vi säga att utgången beror på tillståndet för den aktuella inmatningen och att nästa inmatning beror på utgången av den föregående inmatningen | I övervakad inlärning fattas beslutet om den ursprungliga inmatningen eller den inmatning som ges i början | ||

| I förstärkningsinlärning är beslutet beroende, så vi ger etiketter till sekvenser av beroende beslut | övervakad inlärning besluten är oberoende av varandra, så etiketter ges till varje beslut. | ||

| Exempel: | Exempel: Schackspel | Exempel: |

Typer av förstärkning: Det finns två typer av förstärkning:

- Positiv –

Positiv förstärkning definieras som när en händelse, som inträffar på grund av ett visst beteende, ökar styrkan och frekvensen av beteendet. Med andra ord har det en positiv effekt på beteendet.Fördelar med förstärkningsinlärning är:

- Maximerar prestationen

- Håller förändring under lång tid

Nackdelar med förstärkningsinlärning:

- För mycket förstärkning kan leda till överbelastning av tillstånd vilket kan försämra resultaten

- Negativ –

Negativ förstärkning definieras som förstärkning av ett beteende eftersom ett negativt tillstånd stoppas eller undviks.Fördelar med förstärkningsinlärning:

- Förstärker beteendet

- Förmåner mot minimistandard för prestationer

Nackdelar med förstärkningsinlärning:

- Det ger endast tillräckligt för att uppfylla minimibeteendet

Flera praktiska tillämpningar av förstärkningsinlärning –

- RL kan användas inom robotteknik för industriell automation.

- RL kan användas inom maskininlärning och databehandling

- RL kan användas för att skapa utbildningssystem som ger skräddarsydd undervisning och material enligt elevernas krav.

RL kan användas i stora miljöer i följande situationer:

- En modell av miljön är känd, men en analytisk lösning finns inte tillgänglig;

- Endast en simuleringsmodell av miljön är given (föremål för simuleringsbaserad optimering)

- Det enda sättet att samla in information om miljön är att interagera med den.