Aprendizagem de reforço é uma área de Aprendizagem de Máquina. Trata-se de tomar medidas adequadas para maximizar a recompensa em uma situação particular. É empregado por vários softwares e máquinas para encontrar o melhor comportamento ou caminho que deve tomar em uma situação específica. A aprendizagem de reforço difere da aprendizagem supervisionada de uma forma que, na aprendizagem supervisionada, os dados de formação têm a chave de resposta, pelo que o modelo é treinado com a resposta correcta em si, enquanto que na aprendizagem de reforço não há resposta, mas o agente de reforço decide o que fazer para realizar a tarefa dada. Na ausência de um conjunto de dados de treinamento, ele é obrigado a aprender com sua experiência.

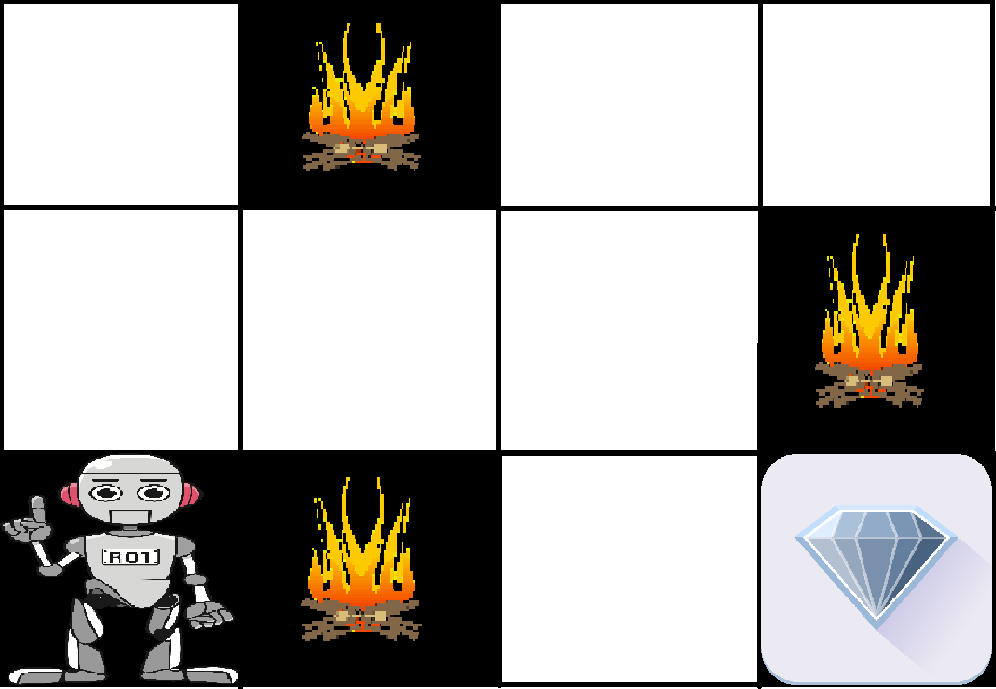

Exemplo: O problema é o seguinte: Temos um agente e uma recompensa, com muitos obstáculos no meio. O agente é suposto encontrar o melhor caminho possível para chegar à recompensa. O seguinte problema explica mais facilmente o problema.

> A imagem acima mostra o robô, o diamante e o fogo. O objetivo do robô é obter a recompensa que é o diamante e evitar os obstáculos que são o fogo. O robô aprende tentando todos os caminhos possíveis e depois escolhendo o caminho que lhe dá a recompensa com os menores obstáculos. Cada passo certo dará ao robô uma recompensa e cada passo errado irá subtrair a recompensa do robô. A recompensa total será calculada quando chegar à recompensa final que é o diamante.

Pontos principais no aprendizado do reforço –

- Ingresso: A entrada deve ser um estado inicial a partir do qual o modelo começará

- Saída: Há muitas saídas possíveis, pois há uma variedade de soluções para um problema particular

- Treinamento: O treinamento é baseado na entrada, O modelo retornará um estado e o usuário decidirá recompensar ou punir o modelo com base em sua saída.

- O modelo continua a aprender.

- A melhor solução é decidida com base na recompensa máxima.

Diferença entre a aprendizagem do Reforço e a aprendizagem supervisionada:

| Aprendizagem de reforço | Aprendizagem supervisionada |

|---|---|

| Aprendizagem de reforço é tudo sobre tomar decisões sequencialmente. Em palavras simples podemos dizer que a saída depende do estado da entrada atual e a próxima entrada depende da saída da entrada anterior | Na aprendizagem supervisionada a decisão é tomada na entrada inicial ou na entrada dada no início |

| Na aprendizagem reforçada a decisão de aprendizagem é dependente, por isso damos etiquetas a seqüências de decisões dependentes | Aprendizagem supervisionada as decisões são independentes umas das outras por isso as etiquetas são dadas a cada decisão. |

| Exemplo: Jogo de xadrez | Exemplo: Reconhecimento de objectos |

Tipos de Reforço: Existem dois tipos de Reforço:

- Positivo –

O Reforço Positivo é definido como quando um evento, ocorre devido a um determinado comportamento, aumenta a força e a frequência do comportamento. Em outras palavras, ele tem um efeito positivo sobre o comportamento.Vantagens da aprendizagem de reforço são:

- Maximiza o desempenho

- Sustenta a mudança por um longo período de tempo

Desvantagens da aprendizagem de reforço:

- O excesso de Reforço pode levar à sobrecarga de estados que podem diminuir os resultados

- Negativo –

O Reforço Negativo é definido como reforço de um comportamento porque uma condição negativa é parada ou evitada.Vantagens da aprendizagem do reforço:

- Aumento do comportamento

- Disponibilizar o padrão mínimo de desempenho

Desvantagens da aprendizagem do reforço:

- Proporciona apenas o suficiente para atingir o comportamento mínimo

Várias aplicações práticas de Aprendizagem de Reforço –

- RL pode ser usado em robótica para automação industrial.

- RL pode ser usado na aprendizagem de máquinas e processamento de dados

- RL pode ser usado para criar sistemas de treinamento que fornecem instruções e materiais personalizados de acordo com as exigências dos alunos.

RL pode ser usado em grandes ambientes nas seguintes situações:

- Um modelo do ambiente é conhecido, mas uma solução analítica não está disponível;

- Apenas um modelo de simulação do ambiente é dado (o assunto da otimização baseada em simulação)

- A única maneira de coletar informações sobre o ambiente é interagir com ele.