Vahvistusoppiminen on koneoppimisen osa-alue. Siinä on kyse sopivien toimien toteuttamisesta palkkion maksimoimiseksi tietyssä tilanteessa. Sitä käyttävät erilaiset ohjelmistot ja koneet löytääkseen parhaan mahdollisen käyttäytymisen tai polun, joka sen tulisi ottaa tietyssä tilanteessa. Vahvistusoppiminen eroaa valvotusta oppimisesta siten, että valvotussa oppimisessa harjoitusdatassa on vastausavain, joten malli koulutetaan itse oikean vastauksen perusteella, kun taas vahvistusoppimisessa vastausta ei ole, vaan vahvistusagentti päättää, mitä tehdä tietyn tehtävän suorittamiseksi. Koulutusdatan puuttuessa sen on pakko oppia kokemuksestaan.

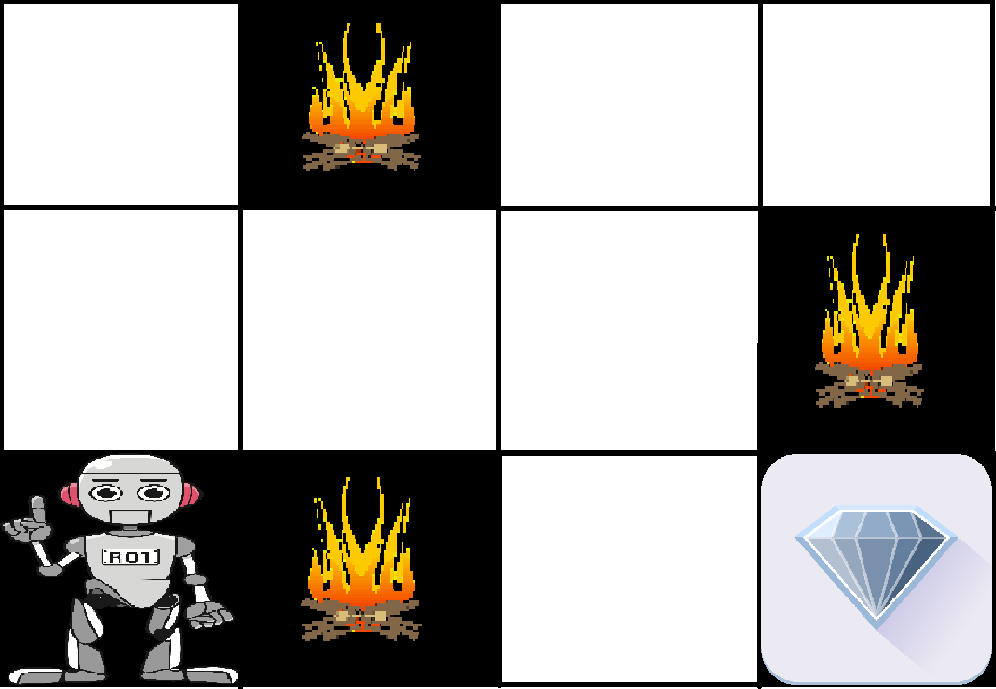

Esimerkki: Ongelma on seuraava: Meillä on agentti ja palkkio, ja välissä on monia esteitä. Agentin on tarkoitus löytää paras mahdollinen polku palkinnon saavuttamiseksi. Seuraava ongelma selittää ongelmaa helpommin.

Yllä olevassa kuvassa on robotti, timantti ja tuli. Robotin tavoitteena on saada palkkio, joka on timantti, ja välttää esteet, jotka ovat tuli. Robotti oppii kokeilemalla kaikkia mahdollisia polkuja ja valitsemalla sitten polun, joka antaa hänelle palkkion ja jossa on vähiten esteitä. Jokainen oikea askel antaa robotille palkkion ja jokainen väärä askel vähentää robotin palkkiota. Kokonaispalkkio lasketaan, kun se saavuttaa lopullisen palkkion, joka on timantti.

Vahvistusoppimisen pääkohdat –

- Input: Syötteen tulee olla alkutila, josta malli lähtee liikkeelle

- Tuotos: Mahdollisia ulostuloja on monia, koska tiettyyn ongelmaan on erilaisia ratkaisuja

- Harjoittelu:

- Malli jatkaa oppimista.

- Paras ratkaisu päätetään maksimipalkkion perusteella.

Ero vahvistusoppimisen ja valvotun oppimisen välillä:

| Vahvistusoppiminen | Valvottu oppiminen |

|---|---|

| Vahvistusoppimisessa tehdään päätöksiä peräkkäin. Yksinkertaisesti sanottuna voidaan sanoa, että ulostulo riippuu nykyisen syötteen tilasta ja seuraava syöttö riippuu edellisen syötteen ulostulosta | Valvotussa oppimisessa päätös tehdään alkusyötteestä tai alussa annetusta syötteestä |

| Vahvistusoppimisessa päätös on riippuvainen, joten annamme merkinnät riippuvaisten päätösten peräkkäisille sarjoille | Valvotussa oppimisessa päätökset ovat toisistaan riippumattomia, joten kullekin päätökselle annamme merkinnät. |

| Esimerkki: Shakkipeli | Esimerkki: |

Vahvistustyypit: Vahvistusta on kahta tyyppiä:

- Positiivinen –

Positiivinen vahvistus määritellään siten, että kun tapahtuma, joka tapahtuu tietyn käyttäytymisen vuoksi, lisää käyttäytymisen voimakkuutta ja taajuutta. Toisin sanoen sillä on positiivinen vaikutus käyttäytymiseen.Vahvistavan oppimisen etuja ovat:

- Maksimoi suorituskykyä

- Säilyttää muutoksen pitkään

Vahvistavan oppimisen haittoja:

- Liian paljon vahvistusta voi johtaa tilojen ylikuormitukseen, joka voi heikentää tuloksia

- Negatiivinen –

Negatiivinen vahvistus määritellään käyttäytymisen vahvistumiseksi, koska negatiivinen tila lopetetaan tai sitä vältetään.Vahvistavan oppimisen edut:

- Vahvistaa käyttäytymistä

- Tarjoaa uhmaa vähimmäissuoritustasoa

Vahvistavan oppimisen haitat:

- Se tarjoaa vain sen verran, että se riittää täyttämään minimikäyttäytymisen

Various Practical applications of Reinforcement Learning –

- RL:ää voidaan käyttää robotiikassa teollisuusautomaatiossa.

- RL:ää voidaan käyttää koneoppimisessa ja tietojenkäsittelyssä

- RL:n avulla voidaan luoda koulutusjärjestelmiä, jotka tarjoavat räätälöityä opetusta ja materiaalia opiskelijoiden vaatimusten mukaan.

RL:ää voidaan käyttää suurissa ympäristöissä seuraavissa tilanteissa:

- Ympäristön malli tunnetaan, mutta analyyttistä ratkaisua ei ole saatavilla;

- Ympäristöstä on annettu vain simulointimalli (simulointipohjaisen optimoinnin kohde)

- Ainoa tapa kerätä tietoa ympäristöstä on olla vuorovaikutuksessa sen kanssa.