強化学習は、機械学習の一分野です。 それは、特定の状況で報酬を最大化するために適切な行動を取ることです。 それは、特定の状況で取るべき最良の可能な動作やパスを見つけるために、様々なソフトウェアやマシンによって採用されています。 強化学習は、教師あり学習と異なり、教師あり学習では、学習データに答えがあるため、正しい答えでモデルが学習されるのに対し、強化学習では、答えはないが、強化エージェントが与えられたタスクを実行するために何をすべきかを決定する、という点で教師あり学習と異なる。 学習データセットがない場合、経験から学習することになる。

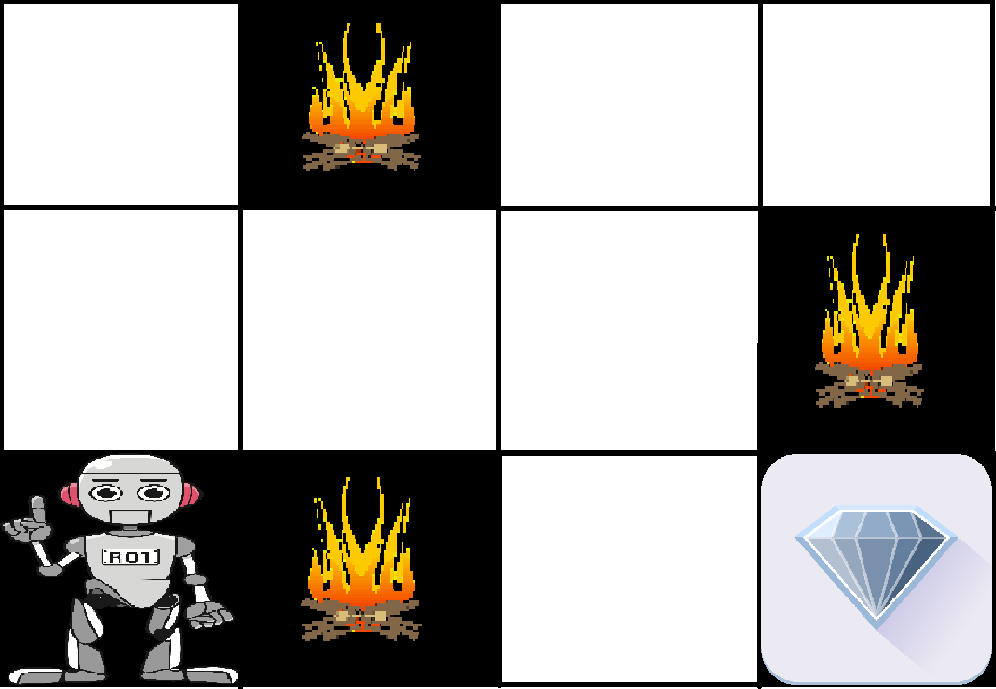

例. 問題は次のようなものである。 エージェントと報酬があり、その間に多くのハードルがある。 エージェントは報酬に到達するための最良の経路を見つけることになっている。 次の問題はこの問題をより簡単に説明している。

上の画像はロボットとダイヤモンドと火である。 ロボットの目標は、ダイヤモンドという報酬を得ることと、火というハードルを避けることである。 ロボットは可能な経路をすべて試し、最もハードルが低く報酬を得られる経路を選ぶことで学習していきます。 正しいステップを踏むごとにロボットに報酬が与えられ、間違ったステップを踏むごとにロボットの報酬が差し引かれます。 報酬の合計は、最終的な報酬であるダイヤモンドに到達した時点で計算されます。

強化学習のポイント –

- インプット。 入力は、モデルがスタートする初期状態でなければならない

- 出力。 特定の問題に対する様々な解があるように、多くの可能な出力がある

- Training:

- モデルは学習を続ける。

- 最良の解決策は、最大の報酬に基づいて決定される。

強化学習 教師あり学習 強化学習は、順次決定を行うことである。 簡単に言うと、出力は現在の入力の状態に依存し、次の入力は前の入力の出力に依存する、ということです Supervised learning では、決定は最初の入力または最初に与えられた入力に対して行われます 強化学習の決定は依存するので、ラベルを依存決定のシーケンスに与えます Supervised learning は決定は互いに独立しているのでラベルはそれぞれの決定に対して与えられます。 例: チェスゲーム 例: 物体認識 強化の種類。

- Positive –

正の強化は、イベントが、特定の行動のために発生し、行動の強さと頻度を増加させるときと定義されています。 つまり、行動に対してポジティブな効果を与えることである。強化学習の長所は:

- Maximizes Performance

- Sustain Change for a long period of time

強化学習の短所は:

- Maximizes Performance

Sustain Change for a long period of time

- Positive –

強化学習が成功する秘訣は?

- 強化が多すぎると、結果を低下させる状態のオーバーロードにつながる可能性がある

否定的強化は、負の状態が停止または回避されているため行動の強化として定義されています。

強化学習の利点:

- 行動を増加させる

- パフォーマンスの最小標準に反抗する

強化学習の欠点。

- 最低限の行動を満たす程度のものしか提供しない

強化学習の様々な実用例 –

- 産業オートメーションのロボット工学でRLを使用することができます。

- RL は機械学習やデータ処理に利用できる

- RL は、生徒の要求に応じてカスタム指導や教材を提供するトレーニングシステムの作成に利用できる。

RL は、次のような状況で大規模環境において使用することができます:

- 環境のモデルはわかっているが、解析的な解がない;

- 環境のシミュレーションモデルだけが与えられている(シミュレーションに基づく最適化の対象);

- 環境についての情報を集める唯一の方法は、それと対話すること;

。