El aprendizaje por refuerzo es un área del aprendizaje automático. Se trata de tomar la acción adecuada para maximizar la recompensa en una situación particular. Es empleado por varios software y máquinas para encontrar el mejor comportamiento posible o el camino que debe tomar en una situación específica. El aprendizaje por refuerzo se diferencia del aprendizaje supervisado en que, en éste, los datos de entrenamiento tienen la clave de la respuesta, por lo que el modelo se entrena con la respuesta correcta por sí mismo, mientras que en el aprendizaje por refuerzo no hay respuesta, sino que el agente de refuerzo decide qué hacer para llevar a cabo una tarea determinada. En ausencia de un conjunto de datos de entrenamiento, está obligado a aprender de su experiencia.

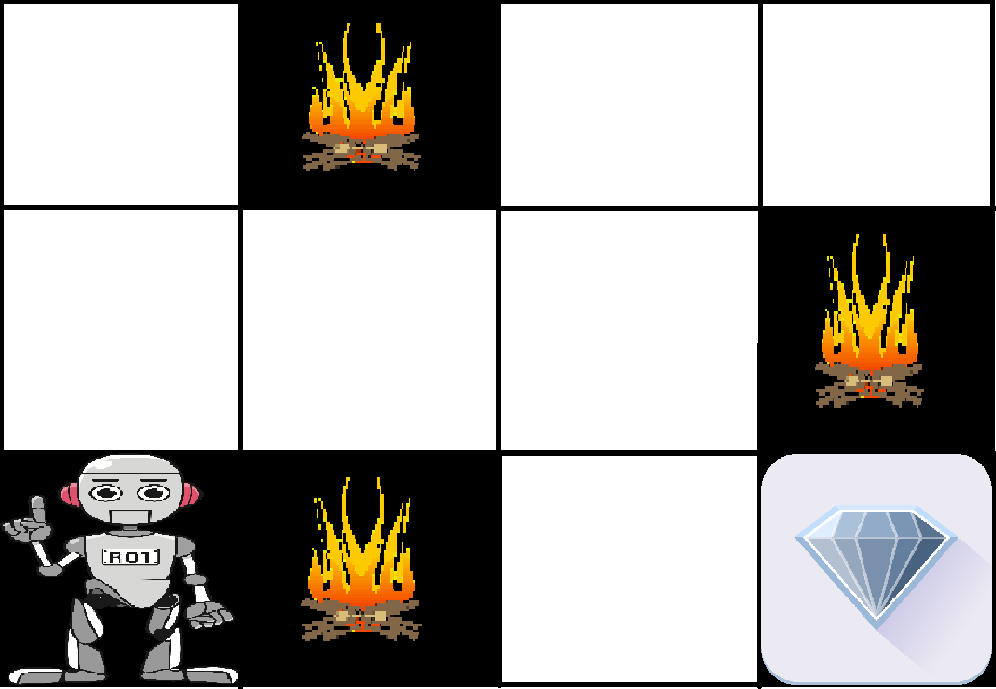

Ejemplo: El problema es el siguiente: Tenemos un agente y una recompensa, con muchos obstáculos de por medio. Se supone que el agente debe encontrar el mejor camino posible para alcanzar la recompensa. El siguiente problema explica el problema más fácilmente.

La imagen anterior muestra el robot, el diamante y el fuego. El objetivo del robot es conseguir la recompensa que es el diamante y evitar los obstáculos que son el fuego. El robot aprende probando todos los caminos posibles y luego eligiendo el camino que le da la recompensa con menos obstáculos. Cada paso correcto le dará al robot una recompensa y cada paso incorrecto le restará la recompensa. La recompensa total se calculará cuando llegue a la recompensa final que es el diamante.

Puntos principales en el aprendizaje por refuerzo –

- Entrada: La entrada debe ser un estado inicial del que partirá el modelo

- Salida: Hay muchas salidas posibles ya que hay variedad de soluciones a un problema concreto

- Entrenamiento: El entrenamiento se basa en la entrada, El modelo devolverá un estado y el usuario decidirá premiar o castigar al modelo en base a su salida.

- El modelo continúa aprendiendo.

- La mejor solución se decide en base a la máxima recompensa.

Diferencia entre el aprendizaje por refuerzo y el aprendizaje supervisado:

| Aprendizaje por refuerzo | Aprendizaje supervisado |

|---|---|

| El aprendizaje por refuerzo consiste en tomar decisiones de forma secuencial. En palabras sencillas podemos decir que la salida depende del estado de la entrada actual y la siguiente entrada depende de la salida de la entrada anterior | En el aprendizaje supervisado la decisión se toma sobre la entrada inicial o la entrada dada al principio |

| En el aprendizaje de refuerzo la decisión es dependiente, por lo que damos etiquetas a las secuencias de decisiones dependientes | En el aprendizaje supervisado las decisiones son independientes unas de otras por lo que se dan etiquetas a cada decisión. |

| Ejemplo: Juego de ajedrez | Ejemplo: Reconocimiento de objetos |

Tipos de Refuerzo: Hay dos tipos de Refuerzo:

- Positivo –

El Refuerzo Positivo se define como cuando un evento, ocurre debido a un comportamiento particular, aumenta la fuerza y la frecuencia del comportamiento. En otras palabras, tiene un efecto positivo en el comportamiento.Las ventajas del aprendizaje por refuerzo son:

- Maximiza el rendimiento

- Sustenta el cambio durante un largo periodo de tiempo

Desventajas del aprendizaje por refuerzo:

- Demasiado Refuerzo puede llevar a una sobrecarga de estados que puede disminuir los resultados

- Negativo –

El Refuerzo negativo se define como el fortalecimiento de una conducta porque se deja de hacer o se evita una condición negativa.Desventajas del aprendizaje por refuerzo:

- Aumenta el comportamiento

- Provoca un desafío al estándar mínimo de rendimiento

Desventajas del aprendizaje por refuerzo:

- Sólo proporciona lo suficiente para cumplir con el comportamiento mínimo

Varias aplicaciones prácticas del aprendizaje por refuerzo –

- El RL se puede utilizar en la robótica para la automatización industrial.

- El RL puede utilizarse en el aprendizaje automático y el procesamiento de datos

- El RL puede utilizarse para crear sistemas de formación que proporcionen instrucción y materiales personalizados según el requisito de los estudiantes.

El RL puede utilizarse en grandes entornos en las siguientes situaciones:

- Se conoce un modelo del entorno, pero no se dispone de una solución analítica;

- Sólo se da un modelo de simulación del entorno (el tema de la optimización basada en la simulación)

- La única forma de recoger información sobre el entorno es interactuar con él.