Dada una muestra de una distribución normal, cuyos parámetros son desconocidos, es posible dar intervalos de predicción en el sentido frecuentista, es decir, un intervalo basado en la estadística de la muestra tal que en experimentos repetidos, Xn+1 cae en el intervalo el porcentaje deseado de las veces; uno puede llamar a estos «intervalos de confianza de predicción».

Una técnica general de intervalos de predicción frecuentista es encontrar y calcular una cantidad pivote de los observables X1, …., Xn, Xn+1 -es decir, una función de observables y parámetros cuya distribución de probabilidad no depende de los parámetros- que puede invertirse para dar una probabilidad de que la futura observación Xn+1 caiga en algún intervalo calculado en términos de los valores observados hasta el momento, X 1 , … , X n . {\displaystyle X_{1},\dots ,X_{n}.}

Tal cantidad pivote, que depende sólo de los observables, se llama estadística auxiliar. El método habitual para construir cantidades pivote es tomar la diferencia de dos variables que dependen de la localización, de modo que la localización se anule, y luego tomar el cociente de dos variables que dependen de la escala, de modo que la escala se anule.La cantidad pivote más conocida es el estadístico t de Student, que puede derivarse por este método y se utiliza en la secuela.

Media conocida, varianza conocidaEditar

Un intervalo de predicción para una observación futura X en una distribución normal N(µ,σ2) con media y varianza conocidas puede calcularse de

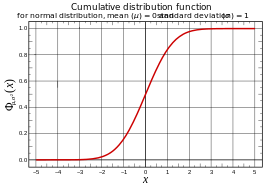

γ = P ( ℓ < X < u ) = P ( ℓ – μ σ < X – μ σ < u – μ σ ) = P ( ℓ – μ σ < Z < u – μ σ ) , {\displaystyle \gamma =P(\ell <X<u)=P\left({\frac {\ell -\mu }{sigma }}<{\frac {X-\mu }{sigma }}<{\frac {u-\derecha)=P\Nleft({\frac {\ell -\mu }{\sigma }}<Z<{\frac {u-\mu }{\sigma }{derecha),

donde Z = X – μ σ {\displaystyle Z={frac {X-\mu }{sigma }}

, la puntuación estándar de X, se distribuye como normal estándar.

Entonces

ℓ – μ σ = – z , u – μ σ = z , {\displaystyle {\frac {\ell -\mu }{\sigma }}=-z,\quad {\frac {u-\mu }{\sigma }=z,}

o

ℓ = μ – z σ , u = μ + z σ , {\displaystyle \ell =\mu -z\sigma ,\quad u=\mu +z\sigma ,}

con z el cuantil de la distribución normal estándar para la cual: γ = P ( – z < Z < z ) . {\displaystyle \gamma =P(-z<Z<z).}

o de forma equivalente;

1 2 ( 1 – γ ) = P ( Z > z ) . {\displaystyle {\tfrac {1}{2}}(1-\gamma )=P(Z>z).}

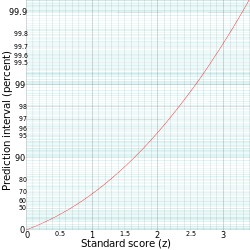

| Predicción intervalo |

z |

|---|---|

| 75% | 1.15 |

| 90% | 1.64 |

| 95% | 1.96 |

| 99% | 2,58 |

El intervalo de predicción se escribe convencionalmente como:

.

Por ejemplo, para calcular el intervalo de predicción del 95% para una distribución normal con una media (µ) de 5 y una desviación estándar (σ) de 1, entonces z es aproximadamente 2. Por lo tanto, el límite inferior del intervalo de predicción es aproximadamente 5 – (2-1) = 3, y el límite superior es aproximadamente 5 + (2-1) = 7, dando así un intervalo de predicción de aproximadamente 3 a 7.

Estimación de los parámetrosEditar

Para una distribución con parámetros desconocidos, una aproximación directa a la predicción es estimar los parámetros y luego utilizar la función cuantil asociada – por ejemplo, se podría utilizar la media muestral X ¯ {\displaystyle {\overline {X}}

como estimación de μ y la varianza muestral s2 como estimación de σ2. Obsérvese que aquí hay dos opciones naturales para s2: dividir por ( n – 1 ) {\displaystyle (n-1)}

produce una estimación insesgada, mientras que al dividir por n se obtiene el estimador de máxima verosimilitud, y se puede utilizar cualquiera de los dos. A continuación, se utiliza la función de cuantiles con estos parámetros estimados Φ X ¯ , s 2 – 1 {\displaystyle \Phi _{overline {X}},s^{2}}^{-1}

para dar un intervalo de predicción.

Este enfoque es utilizable, pero el intervalo resultante no tendrá la interpretación de muestreo repetido – no es un intervalo de confianza de predicción.

Para la secuela, utilice la media muestral:

X ¯ = X ¯ n = ( X 1 + ⋯ + X n ) / n {\displaystyle {\overline {X}}={\overline {X}}_{n}=(X_{1}+\cdots +X_{n})/n}

y la varianza muestral (insesgada):

s 2 = s n 2 = 1 n – 1 ∑ i = 1 n ( X i – X ¯ n ) 2 . {\displaystyle s^{2}=s_{n}^{2}={1 \over n-1}\sum _{i=1}^{n}(X_{i}-{\overline {X}_{n})^{2}.}

Media desconocida, varianza conocidaEditar

Dada una distribución normal con media desconocida μ pero varianza conocida 1, la media muestral X ¯ {\displaystyle {\overline {X}}

de las observaciones X 1 , … , X n {\displaystyle X_{1},\dots ,X_{n}}

tiene una distribución N ( μ , 1 / n ) , {\displaystyle N(\mu ,1/n),}

mientras que la futura observación X n + 1 {\displaystyle X_{n+1}}

tiene una distribución N ( μ , 1 ) . {\displaystyle N(\mu ,1).}

Tomando la diferencia de éstas se cancela la μ y se obtiene una distribución normal de varianza 1 + ( 1 / n ) , {\displaystyle 1+(1/n),}

por tanto X n + 1 – X ¯ 1 + ( 1 / n ) ∼ N ( 0 , 1 ) . {\displaystyle {\frac {X_{n+1}-{overline {X}} {{sqrt {1+(1/n)}}sim N(0,1).}

Resolver para X n + 1 {\displaystyle X_{n+1}}

da la distribución de predicción N ( X ¯ , 1 + ( 1 / n ) ) , {\displaystyle N({\overline {X}},1+(1/n)),}

a partir de la cual se pueden calcular intervalos como antes. Este es un intervalo de confianza predictivo en el sentido de que si uno utiliza un rango cuantílico de 100p%, entonces en aplicaciones repetidas de este cálculo, la observación futura X n + 1 {\displaystyle X_{n+1}}

caerá en el intervalo predicho el 100p% de las veces.

Nótese que esta distribución de predicción es más conservadora que el uso de la media estimada X ¯ {\displaystyle {\overline {X}}

y la varianza conocida 1, ya que esto utiliza la varianza 1 + ( 1 / n ) {\displaystyle 1+(1/n)}

, por lo que se obtienen intervalos más amplios. Esto es necesario para que se mantenga la propiedad deseada del intervalo de confianza.

Media conocida, varianza desconocidaEditar

A la inversa, dada una distribución normal con media conocida 0 pero varianza desconocida σ 2 {\displaystyle \sigma ^{2}}

, la varianza muestral s 2 {\displaystyle s^{2}}

de las observaciones X 1 , … , X n {\displaystyle X_{1},\dots ,X_{n}}

tiene, hasta la escala, un χ n – 1 2 {\displaystyle \scriptstyle \chi _{n-1}^{2}}

distribución; más precisamente: ( n – 1 ) s n 2 σ 2 ∼ χ n – 1 2 . {\displaystyle {\frac {(n-1)s_{n}^{2}} {{sigma ^{2}} {\sim \chi _{n-1}^{2}.}

mientras que la futura observación X n + 1 {\displaystyle X_{n+1}}

tiene una distribución N ( 0 , σ 2 ) . {\displaystyle N(0,\sigma ^{2}).}

Si se toma el cociente entre la observación futura y la desviación estándar de la muestra se anula la σ, dando lugar a una distribución t de Student con n – 1 grados de libertad: X n + 1 s ∼ T n – 1 . {\displaystyle {\frac {X_{n+1}}{sim T^{n-1}}.

Resolviendo para X n + 1 {\displaystyle X_{n+1}}

da la distribución de predicción s T n – 1 , {\displaystyle sT^{n-1},}

a partir de la cual se pueden calcular los intervalos como antes.

Nótese que esta distribución de predicción es más conservadora que el uso de una distribución normal con la desviación estándar estimada s {\displaystyle s}

y la media conocida 0, ya que utiliza la distribución t en lugar de la distribución normal, por lo que produce intervalos más amplios. Esto es necesario para que se mantenga la propiedad deseada del intervalo de confianza.

Media desconocida, varianza desconocidaEditar

Combinando lo anterior para una distribución normal N ( μ , σ 2 ) {\displaystyle N(\mu ,\sigma ^{2})}

con ambas μ y σ2 desconocidas se obtiene el siguiente estadístico auxiliar: X n + 1 – X ¯ n s n 1 + 1 / n ∼ T n – 1 . {\displaystyle {\frac {X_{n+1}-{overline {X}}_{n}{s_{n}{sqrt {1+1/n}}}}\sim T^{n-1}.}

Esta sencilla combinación es posible porque la media muestral y la varianza muestral de la distribución normal son estadísticos independientes; esto sólo es cierto para la distribución normal, y de hecho caracteriza a la distribución normal.

Resolviendo para X n + 1 {{displaystyle X_{n+1}}

se obtiene la distribución de predicción X ¯ n + s n 1 + 1 / n ⋅ T n – 1 . {\displaystyle {\overline {X}_{n}+s_{n}{sqrt {1+1/n}\cdot T^{n-1}.}

La probabilidad de X n + 1 {\displaystyle X_{n+1}}

que caiga en un intervalo dado es entonces: Pr ( X ¯ n – T a s n 1 + ( 1 / n ) ≤ X n + 1 ≤ X ¯ n + T a s n 1 + ( 1 / n ) ) = p {\displaystyle \Pr \left({\overline {X}_{n}-T_{a}s_{n} {{sqrt} {1+(1/n)}{leq} X_{n+1}{leq} {{sobrelínea {X}}_{n}+T_{a}s{{{n}{sqrt} {1+(1/n)},\derecha)=p}