Donné un échantillon d’une distribution normale, dont les paramètres sont inconnus, il est possible de donner des intervalles de prédiction au sens fréquentiste, c’est-à-dire, un intervalle basé sur des statistiques de l’échantillon telles que, lors d’expériences répétées, Xn+1 tombe dans l’intervalle le pourcentage de temps désiré ; on peut appeler cela des « intervalles de confiance prédictifs ».

Une technique générale d’intervalles de prédiction fréquentistes consiste à trouver et à calculer une quantité pivot des observables X1, …., Xn, Xn+1 – c’est-à-dire une fonction des observables et des paramètres dont la distribution de probabilité ne dépend pas des paramètres – qui peut être inversée pour donner une probabilité que l’observation future Xn+1 tombe dans un certain intervalle calculé en termes de valeurs observées jusqu’à présent, X 1 , … , X n . {\displaystyle X_{1},\dots ,X_{n}.}

Une telle quantité pivot, dépendant uniquement des observables, est appelée statistique auxiliaire. La méthode habituelle de construction des quantités pivots consiste à prendre la différence de deux variables qui dépendent de la localisation, de façon à ce que la localisation s’annule, puis à prendre le rapport de deux variables qui dépendent de l’échelle, de façon à ce que l’échelle s’annule.La quantité pivot la plus connue est la statistique t de Student, qui peut être dérivée par cette méthode et qui est utilisée dans la suite.

Moyenne connue, variance connueEdit

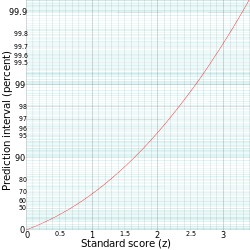

Un intervalle de prédiction pour une observation future X dans une distribution normale N(µ,σ2) avec moyenne et variance connues peut être calculé à partir de

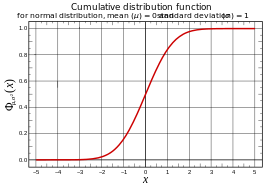

γ = P ( ℓ < X < u ) = P ( ℓ – μ σ < X – μ σ < u – μ σ ) = P ( ℓ – μ σ < Z < u – μ σ ) , {\displaystyle \gamma =P(\ell <X<u)=P\left({\frac {\ell -\mu }{\sigma }}<{\frac {X-\mu }{\sigma }}<{\frac {u-\mu }{\sigma }}} droite)=P\left({\frac {\ell -\mu }{\sigma }}<Z<{\frac {u-\mu }{\sigma }} droite),

où Z = X – μ σ {\displaystyle Z={\frac {X-\mu }{\sigma }}

, le score standard de X, est distribué comme une normale standard.

Hence

ℓ – μ σ = – z , u – μ σ = z , {\displaystyle {\frac {\ell -\mu }{\sigma }}=-z,\quad {\frac {u-\mu }{\sigma }}=z,}

ou

ℓ = μ – z σ , u = μ + z σ , {\displaystyle \ell =\mu -z\sigma ,\quad u=\mu +z\sigma ,}

avec z le quantile dans la distribution normale standard pour laquelle :

γ = P ( – z < Z < z ) . {\displaystyle \gamma =P(-z<Z<z).}

ou de manière équivalente;

1 2 ( 1 – γ ) = P ( Z > z ) . {\displaystyle {\tfrac {1}{2}}(1-\gamma )=P(Z>z).}

| Prédiction intervalle |

z |

|---|---|

| 75% | 1.15 |

| 90% | 1.64 |

| 95% | 1.96 |

| 99% | 2,58 |

L’intervalle de prédiction est conventionnellement écrit comme:

. {\displaystyle \left.}

Par exemple, pour calculer l’intervalle de prédiction à 95% pour une distribution normale avec une moyenne (µ) de 5 et un écart-type (σ) de 1, alors z est approximativement 2. Par conséquent, la limite inférieure de l’intervalle de prédiction est approximativement 5 – (2-1) = 3, et la limite supérieure est approximativement 5 + (2-1) = 7, ce qui donne un intervalle de prédiction d’environ 3 à 7.

Estimation des paramètresEdit

Pour une distribution dont les paramètres sont inconnus, une approche directe de la prédiction consiste à estimer les paramètres puis à utiliser la fonction quantile associée – par exemple, on pourrait utiliser la moyenne de l’échantillon X ¯ {\displaystyle {\overline {X}}.

comme estimation de μ et la variance de l’échantillon s2 comme estimation de σ2. Notez qu’il y a deux choix naturels pour s2 ici – diviser par ( n – 1 ) {\displaystyle (n-1)}.

donne une estimation sans biais, tandis que la division par n donne l’estimateur du maximum de vraisemblance, et l’un ou l’autre peut être utilisé. On utilise alors la fonction quantile avec ces paramètres estimés Φ X ¯ , s 2 – 1 {\displaystyle \Phi _{{\overline {X}},s^{2}}^{-1}}.

pour donner un intervalle de prédiction.

Cette approche est utilisable, mais l’intervalle résultant n’aura pas l’interprétation de l’échantillonnage répété – ce n’est pas un intervalle de confiance prédictif.

Pour la suite, on utilise la moyenne de l’échantillon :

X ¯ = X ¯ n = ( X 1 + ⋯ + X n ) / n {\displaystyle {\overline {X}}={\overline {X}}_{n}=(X_{1}+\cdots +X_{n})/n}.

et la variance (sans biais) de l’échantillon :

s 2 = s n 2 = 1 n – 1 ∑ i = 1 n ( X i – X ¯ n ) 2 . {\displaystyle s^{2}=s_{n}^{2}={1 \over n-1}\sum _{i=1}^{n}(X_{i}-{\overline {X}}_{n})^{2}.}

Moyenne inconnue, variance connueEdit

Sous réserve d’une distribution normale de moyenne inconnue μ mais de variance connue 1, la moyenne de l’échantillon X ¯ {\displaystyle {\overline {X}}}.

des observations X 1 , … , X n {\displaystyle X_{1},\dots ,X_{n}}

a une distribution N ( μ , 1 / n ) , {\displaystyle N(\mu ,1/n),}

tandis que l’observation future X n + 1 {\displaystyle X_{n+1}}.

a une distribution N ( μ , 1 ) . {\displaystyle N(\mu ,1).}

Prendre la différence de ceux-ci annule le μ et donne une distribution normale de variance 1 + ( 1 / n ) , {\displaystyle 1+(1/n),}

donc X n + 1 – X ¯ 1 + ( 1 / n ) ∼ N ( 0 , 1 ) . {\displaystyle {\frac {X_{n+1}-{{overline {X}}{\sqrt {1+(1/n)}}}\sim N(0,1).}

Résolution pour X n + 1 {\displaystyle X_{n+1}}.

donne la distribution de prédiction N ( X ¯ , 1 + ( 1 / n )). , {\displaystyle N({\overline {X}},1+(1/n)),}

à partir de laquelle on peut calculer des intervalles comme précédemment. Il s’agit d’un intervalle de confiance prédictif en ce sens que si l’on utilise une plage de quantiles de 100p%, alors lors d’applications répétées de ce calcul, l’observation future X n + 1 {\displaystyle X_{n+1}}.

tombera dans l’intervalle prédit 100p% du temps.

Notez que cette distribution de prédiction est plus conservatrice que l’utilisation de la moyenne estimée X ¯ {\displaystyle {\overline {X}}}.

et la variance connue 1, car cela utilise la variance 1 + ( 1 / n ) {\displaystyle 1+(1/n)}.

, ce qui donne des intervalles plus larges. Ceci est nécessaire pour que la propriété d’intervalle de confiance souhaitée soit respectée.

Moyenne connue, variance inconnueEdit

A l’inverse, étant donné une distribution normale avec une moyenne connue 0 mais une variance inconnue σ 2 {\displaystyle \sigma ^{2}}.

, la variance de l’échantillon s 2 {\displaystyle s^{2}}

des observations X 1 , … , X n {\displaystyle X_{1},\dots ,X_{n}}

a, jusqu’à l’échelle, un χ n – 1 2 {\displaystyle \scriptstyle \chi _{n-1}^{2}}

distribution ; plus précisément : ( n – 1 ) s n 2 σ 2 ∼ χ n – 1 2 . {\displaystyle {\frac {(n-1)s_{n}^{2}}{\sigma ^{2}}}\sim \chi _{n-1}^{2}.}

alors que l’observation future X n + 1 {\displaystyle X_{n+1}}.

a une distribution N ( 0 , σ 2 ) . {\displaystyle N(0,\sigma ^{2}).}

En prenant le rapport entre l’observation future et l’écart type de l’échantillon, on annule le σ, ce qui donne une distribution t de Student à n – 1 degrés de liberté : X n + 1 s ∼ T n – 1 . {\displaystyle {\frac {X_{n+1}}{s}}\sim T^{n-1}.}

Solving for X n + 1 {\displaystyle X_{n+1}}

donne la distribution de prédiction s T n – 1 , {\displaystyle sT^{n-1},}

à partir de laquelle on peut calculer les intervalles comme précédemment.

Notez que cette distribution de prédiction est plus conservatrice que l’utilisation d’une distribution normale avec l’écart type estimé s {\displaystyle s}.

et la moyenne connue 0, car elle utilise la distribution t au lieu de la distribution normale, donc donne des intervalles plus larges. Ceci est nécessaire pour que la propriété d’intervalle de confiance souhaitée soit respectée.

Moyenne inconnue, variance inconnueEdit

Combinaison de ce qui précède pour une distribution normale N ( μ , σ 2 ) {\displaystyle N(\mu ,\sigma ^{2})}.

avec μ et σ2 inconnus donne la statistique auxiliaire suivante : X n + 1 – X ¯ n s n 1 + 1 / n ∼ T n – 1 . {\displaystyle {\frac {X_{n+1}-{{overline {X}}_{n}}{s_{n}{\sqrt {1+1/n}}}}\sim T^{n-1}.}

Cette combinaison simple est possible parce que la moyenne et la variance d’échantillon de la distribution normale sont des statistiques indépendantes ; ceci n’est vrai que pour la distribution normale, et caractérise en fait la distribution normale.

Résolution pour X n + 1 {\displaystyle X_{n+1}}.

donne la distribution de prédiction X ¯ n + s n 1 + 1 / n ⋅ T n – 1 . {\displaystyle {\overline {X}_{n}+s_{n}{\sqrt {1+1/n}}\cdot T^{n-1}.}

La probabilité de X n + 1 {\displaystyle X_{n+1}}.

tombant dans un intervalle donné est alors : Pr ( X ¯ n – T a s n 1 + ( 1 / n ) ≤ X n + 1 ≤ X ¯ n + T a s n 1 + ( 1 / n ) ) = p {\displaystyle \Pr \left({\overline {X}}_{n}-T_{a}s_{n}{\sqrt {1+(1/n)}}\leq X_{n+1}\leq {\overline {X}_{n}+T_{a}s_{n}{\sqrt {1+(1/n)}}\,\right)=p}